Jak zjistit normální distribuci

Jak zjistit normální distribuci

Normální distribuce (je to stejná distribuceGauss) má omezující povahu. Pro něj za určitých podmínek se všechny ostatní distribuce sbližují. Proto jsou některé charakteristiky normálních náhodných proměnných extrémní. Toto se použije při odpovědi na otázku.

Pokyny

1

Chcete-li odpovědět na otázku, je náhodnáhodnota normální, můžeme nakreslit koncept entropie H (x), který vzniká v teorii informace. Bodem je, že každá diskrétní zpráva tvořená z n symbolů X = {x1, x2, ... xn}, může být chápána jako diskrétní náhodná proměnná daná sérií pravděpodobností. Pokud se pravděpodobnost použití symbolu, např. X5 rovná P5, je pravděpodobnost události X = x ta stejná. Z teorie termínů informací pojďme pojetí množství informací (přesněji naše vlastní informace) I (xi) = ℓog (1 / P (xi)) = - ℓogP (xi). Pro stručnost zadejte P (xi) = Pi. Logaritmy zde jsou vzaty na základě 2. V konkrétních projevech se tyto důvody nezaznamenávají. Proto, mimochodem, je binární číslice (binární číslice) trochu.

2

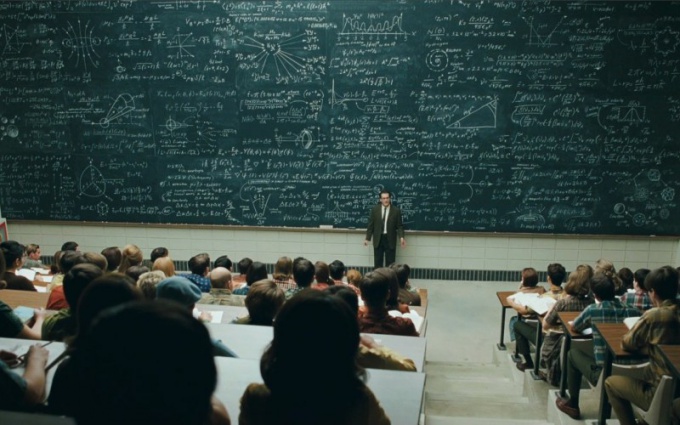

Entropie je průměrný početinformace v jedné hodnotě náhodné proměnné H (x) = M [-logogi] = - ΣPi ∙ ℓogPi (součet je přes i od 1 do n). A má nepřetržité rozdělení. Chcete-li vypočítat entropii kontinuální náhodné proměnné, představte ji v diskrétní podobě. Rozdělte část rozsahu hodnot na malé intervaly Δx (kvantizační krok). Jako možnou hodnotu si vezměte střed příslušné Δx a namísto její pravděpodobnosti použijte plošný prvek Piβw (xi) Δx. Situace je znázorněna na obr. 1. Ukazuje, až na malé detaily, Gaussovu křivku, která je grafickým znázorněním hustoty pravděpodobnosti normální distribuce. Zde je uveden vzorec pro pravděpodobnost hustoty tohoto rozdělení. Pečlivě zvažte tuto křivku, porovnejte ji s údaji, které máte. Možná odpověď na otázku již byla vyřešena? Pokud tomu tak není, stojí za to pokračovat.

3

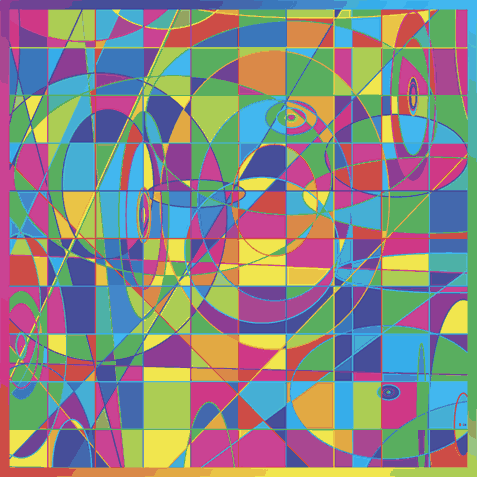

Použijte metodiku navrženou v předchozímkrok. Proveďte několik pravděpodobností nyní diskrétní náhodné proměnné. Najděte jeho entropii a přejděte k souvislé distribuci jako n → ∞ (Δx → 0). Všechny výpočty jsou znázorněny na obr. 2.

4

Lze dokázat, že normální (Gaussovský)distribuce mají maximální entropii ve srovnání se všemi ostatními. Prostřednictvím jednoduchého výpočtu pomocí konečného vzorce předchozího kroku H (x) = M [-logw (x)] najděte tuto entropii. Není zapotřebí integrace. Vlastnosti matematického očekávání jsou dostatečné. Získáme H (x) = ℓog2 (σχ√ (2πe)) = ℓog2 (σχ) + ℓog2 (√ (2πe)) ≈ℓog2 (σx) +2,045. To je maximální možný. Nyní s využitím jakýchkoli údajů o distribuci, která máte k dispozici (počínaje jednoduchou statistickou populací), najděte její odchylku Dx = (σx) ². Nahraďte vypočtený σx do výrazu pro maximální entropii. Vypočítejte entropii náhodné proměnné H (x), kterou zkoumáte.

5

Proveďte poměr H (x) / Hmax (x) = ε. Nezávisle vybereme pravděpodobnost εo, která může být považována za téměř jednotnou při rozhodování o blízkosti vaší distribuce a normální. Řekněte pravděpodobné pravděpodobnosti. Doporučují se hodnoty vyšší než 0,95. Pokud se ukázalo, že ε> εo, potom (s pravděpodobností alespoň ε0) se vypořádáte s Gaussovou distribucí.